深入理解CPU和异构计算芯片GPU/FPGA/ASIC

cathy -- 周二, 03/09/2021 - 17:31

随着互联网用户的快速增长,数据体量的急剧膨胀,数据中心对计算的需求也在迅猛上涨。

GPU,全称为图形处理单元(Graphics Processing Unit),是一种专用于处理图形和图像计算的处理器。起初,GPU主要用于图形渲染,但随着计算需求的增加,尤其是在科学计算、深度学习和其他并行计算领域,GPU的通用计算能力逐渐受到重视。

GPU相对于传统的中央处理单元(CPU)在设计上有一些显著的区别。CPU更适用于处理通用的控制流任务,而GPU则专注于高度并行的数据处理。GPU通常拥有大量的小型处理单元,被设计成能够同时处理大量相似的任务,例如图形渲染中的像素计算或深度学习中的矩阵运算。

总体而言,GPU在图形处理领域的成功应用和对并行计算需求的响应使其逐渐演变成为通用计算设备,广泛用于加速各种科学和工程计算应用。

随着互联网用户的快速增长,数据体量的急剧膨胀,数据中心对计算的需求也在迅猛上涨。

早期的机器学习以搜索为基础,主要依靠进行过一定优化的暴力方法。但是随着机器学习逐渐成熟,它开始专注于加速技术已经很成熟的统计方法和优化问题。同时深度学习的问世更是带来原本可能无法实现的优化方法。本文将介绍现代机器学习如何找到兼顾规模和速度的新方法。

早期的机器学习以搜索为基础,主要依靠进行过一定优化的暴力方法。但是随着机器学习逐渐成熟,它开始专注于加速技术已经很成熟的统计方法和优化问题。同时深度学习的问世更是带来原本可能无法实现的优化方法。本文将介绍现代机器学习如何找到兼顾规模和速度的新方法。

FPGA 是一堆晶体管,你可以把它们连接(wire up)起来做出任何你想要的电路。它就像一个纳米级面包板。使用 FPGA 就像芯片流片,但是你只需要买这一张芯片就可以搭建不一样的设计,作为交换,你需要付出一些效率上的代价。

IDC《2018年下半年中国AI基础架构市场跟踪报告》显示,2018年下半年中国GPU服务器市场规模为7.8亿美金(约合人民币53.8亿元),同比增长107.3%。 2018年全年中国GPU服务器市场规模为13.05亿美金(约合人民币90.05亿元),同比增长131.2%。

目前大多数的机器学习是在处理器上完成的,大多数机器学习软件会针对GPU进行更多的优化,甚至有人认为学习加速必须在GPU上才能完成,但事实上无论是运行机器学习的处理器还是优化的深度学习框架,都不单只针对GPU,代号为“Skylake”的英特尔至强SP处理器就证明了这一点。

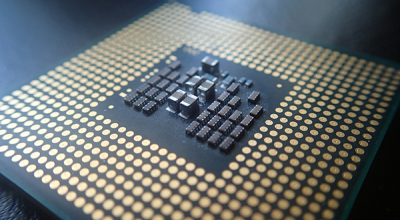

CPU和GPU都是具有运算能力的芯片,CPU更像“通才”——指令运算(执行)为重+ 数值运算,GPU更像“专才”——图形类数值计算为核心。在不同类型的运算方面的速度也就决定了它们的能力——“擅长和不擅长”。

芯片的速度主要取决于三个方面:微架构、主频、IPC(每个时钟周期执行的指令数)。

1.微架构

就如电源是PC的心脏一样,主板和显卡上的供电模块也是它们各自的心脏,搭载在身上的各种芯片能否正常工作,就看它们的供电电路是否足够强悍了。因此,在我们的显卡和主板评测中,它们的供电模块会是一个很重要的评分项目。那么主板和显卡上的供电模块由什么元件组成,又是如何工作的呢?今天我们就来扒一扒那些关于板卡供电模块的二三事。

CPU和GPU之所以大不相同,是由于其设计目标的不同,它们分别针对了两种不同的应用场景。CPU需要很强的通用性来处理各种不同的数据类型,同时又要逻辑判断,还会引入大量的分支跳转和中断的处理。这些都使得CPU的内部结构异常复杂,而GPU面对的则是类型高度统一的、相互无依赖的大规模数据和不需要被打断的纯净的计算环境。

目前大部分电子产品在用户体验升级方面通常从交互方式入手,而通常的思路就是将传统按键交互来使用GUI来替代。