作者:Jürgen

在经历了一个多世纪的研究后,人工智能 (AI) 最近变成了一个热门并且异常重要的领域。尤其值得一提的是,模式识别和机器学习已经发展到深度学习 (DL),这是一个比较新的名称,指的是从经验中学习的人工神经网络 (NN)。DL目前已广泛应用到了工业和日常生活中。您智能手机上的图像和语音识别,以及从一种语言到另一种语言的自动翻译,就是DL发挥作用的两个例子。

在讲英语的盎格鲁文化圈中,许多人以为DL是盎格鲁文化圈国家的一项发明创造。但实际上,DL却是在英语并非官方语言的国家发明的。首先,让我们把目光投向过去,以整个计算史为背景了解AI的发展进程。

早期的计算先行者

安提基特拉机械 (Antikythera Mechanism) 于公元前一世纪在希腊建造,是最早的机械计算机器之一。该装置通过37个大小各异的齿轮运转,用于预测天文现象 (图1)。

安提基特拉机械的先进性在其后1600年内一直未被超越,直到纽伦堡的彼得·亨利因 (Peter Henlein) 于1505年开始制造小型怀表。但是,与安提基特拉机械一样,亨利因的机械也不是针对用户给出的输入来计算结果的通用机器。它们只是使用齿轮比来对时间做除法而已。手表将秒数除以60得到分钟数,将分钟数除以60得到小时数。

但在1623年,图宾根的威廉·希卡德 (Wilhelm Schickard) 建造了首台进行基本算数的自动计算机。紧随其后的是1640年布莱斯·帕斯卡 (Blaise Pascal) 的Pascaline加法器。随后在1670年,戈特弗里德·威廉·莱布尼茨 (Gottfried Wilhelm Leibniz) 发明了步进计算器,这是首台能够进行加、减、乘、除所有四种基本运算的机器。1703年,莱布尼茨发表了《二进制算术阐释》(Explanation of Binary Mathematics),这就是现在几乎所有现代计算机上都在使用的二进制计算方法。

数学分析和数据科学也在不断发展。大约在1800年,卡尔·弗里德里希·高斯 (Carl Friedrich Gauss) 和阿德里安-马里·勒让德 (Adrien-Marie Legendre) 通过线性回归(现在有时称为“浅层学习”)发展出了模式识别的最小二乘法。高斯就是使用了这种算法让人们再次观测到小行星谷神星。他分析了先前观测的数据点,然后使用多种技巧来调整预测算式的参数,从而准确预测了谷神星再次出现的位置,这让高斯名声大噪。

差不多在同一个时期,法国出现了第一台实用的程控机器:由穿孔卡片编程的自动织布机。1800年左右,约瑟夫·玛丽·雅卡尔 (Joseph Marie Jacquard) 和同事就此成为了第一批事实上的程序员。

1837年,英格兰的查尔斯·巴贝奇 (Charles Babbage) 设计了被称为“分析机”的更通用的程控机器。当时没有人能够把它造出来,也许是因为它的设计仍然基于繁琐的十进制而不是莱布尼兹的二进制运算。不过,至少他设计的通用性次之的“差分机2号”在1991年造出的样机表明能够运行。

20世纪伊始,智能机器方向上的进步大大加快。以下列出了1900年以来与AI发展相关的主要里程碑:

1、1914年,西班牙人莱昂纳多·托雷斯·伊·克维多 (Leonardo Torres y Quevedo) 使用电磁元件建造了第一台国际象棋自动机。它能从任何位置开始完成王车残局而无需人工干预。当时,国际象棋被认为是一种高智力水平的活动。

2、1931年,奥地利人库尔特·哥德尔 (Kurt Gödel) 提出了第一种基于整数的通用编码语言,从而成为AI理论以及整个理论计算机科学的奠基者。他用这种编码语言来描述通用的计算定理证明器,确定数学、运算和AI的基本限制。1960年代和1970年代,AI和专家系统中许多后来的工作都将哥德尔的方法应用于定理证明和推论。

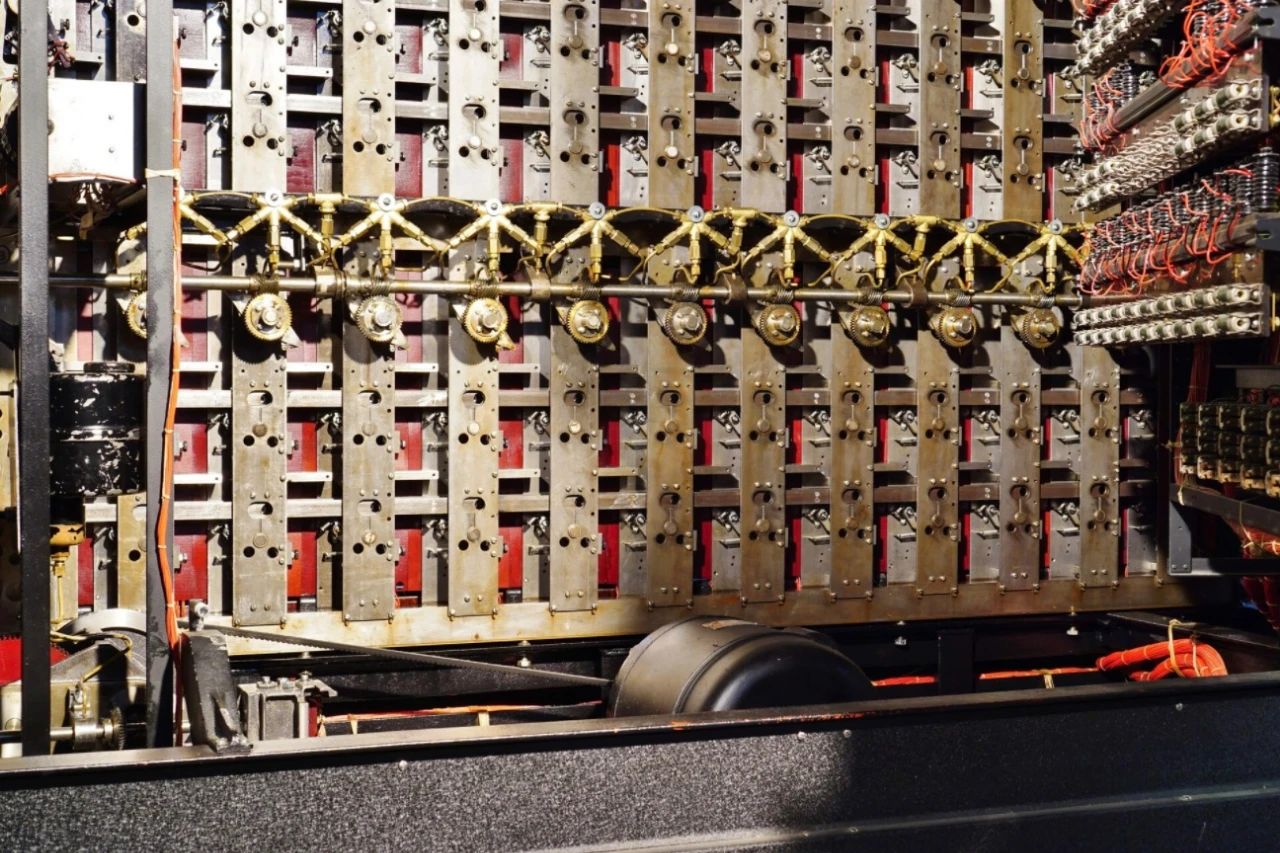

3、1935年,美国数学家阿隆佐·邱齐 (Alonzo Church) 发表了哥德尔1931年成果的扩展,解决了“可判定性难题”,也就是决策难题,引入了被称为“λ演算”的替代通用语言。这便是流行编程语言LISP的基础。英国的艾伦·图灵 (Alan Turing) 在1936年使用了另一种同样强大的理论结构重新构造了这项成果,现在这种结构被称为“图灵机” (图2)。他还提出了一种主观AI测试。

4、1935年至1941年间,康拉德·楚泽 (Konrad Zuse) 建造了第一台具有实用意义并且可以工作的程序控制计算机Z3。在1940年代,他还设计了第一种高级编程语言,并用它编写了第一个通用国际象棋程序。1950年,楚泽制造出世界第一台商用计算机Z4,比第一台UNIVAC早了几个月。

5、尽管“AI”这一名称是约翰·麦卡锡 (John McCarthy) 在1956年的达特茅斯会议上创造的,但早在五年之前,在巴黎举办的著名的计算机与人类思想大会 (“Les Machines à Calculer et la Pensee Humaine”) 上就已讨论这个主题。赫伯特·布鲁德勒 (Herbert Bruderer) 非常恰当地将其称为首次关于AI的大会。在那次有数百名世界专家参加的会议上,诺伯特·维纳 (Norbert Wiener) 和前面提到的托雷斯·伊·克维多著名的国际象棋机进行了一场对局。

6、20世纪50年代后期,弗兰克·罗森布拉特 (Frank Rosenblatt) 开发了用于“浅层神经网络”的感知机和简单学习的算法。这些实际上是高斯和勒让德在1800年左右推出的古老线性回归器的变形。罗森布拉特后来还考虑过更深度的网络,但并未取得太多进展。

7、1965年,两位乌克兰人阿列克谢·伊瓦赫年科 (Alexey Ivakhnenko) 和瓦伦丁·拉帕 (Valentin Lapa) 发表了第一篇有关具有任意层数的深层多层感知机学习算法的文章。如果说前馈网络领域中有一位“深度学习之父”,一定非伊瓦赫年科莫属。即使按照2000年以后的标准,他的网络也属于深层 (达到8层)。和如今的深度神经网络类似,他的网络能够通过学习来创建分层和分布式的传入数据内部表述。最近几十年来,深度学习变得非常重要。它是AI的一个专门化分支,在某种程度上与人脑有关;人脑包含大约1000亿个神经元,每个神经元都与1万个其他神经元相连接。其中有些是输入神经元,可为其他神经元提供数据(听觉、视觉、触觉、痛觉、饥饿感)。还有一些神经元是输出神经元,可以控制肌肉。大多数神经元隐藏于二者之间,思维就在这些神经元中进行。大脑通过改变连接的强度或权重来学习,这些连接决定了神经元相互影响的强度,并对一生中的所有经历进行编码。如今的深度学习人工神经网络正是由此获得启发,能够比之前的方法更好地学习。

8、1969年,马文·明斯基 (Marvin Minsky) 和西摩·佩珀特 (Seymour Papert) 的出名著作《Perceptrons: an introduction to computational geometry》(感知机:计算几何学导论) 介绍了浅层学习的局限性,探讨了这个实际上已在4年前由阿列克谢·伊瓦赫年科和瓦伦丁·拉帕解决的问题。有人说明斯基的书延缓了与神经网络有关的研究,但事实并非如此,或者说在美国之外进行的研究肯定不是这种情况。在随后的几十年里,许多研究者 (尤其是在东欧) 以伊瓦赫年科等人的成果为基础继续研究。即使是在2000年代,人们仍在使用他被广泛引用的方法来训练深层网络。

人工智能的火热,令人们都以为这是近年发明的新科技,但其实人工智能的发展在人类历史可算是源远流长,令人意想不到。

Jürgen Schmidhuber经常被媒体誉为「现代人工智能之父」。他在大约15岁时就希望能开发一种比他自己更聪明、能够自我完善的人工智能 (AI),并以此作为退休之前的主攻目标。他的实验室自1991年起引领了深度学习神经网络的研究,提出了包括长短期记忆 (LSTM) 在内的多项技术,为机器学习领域带来了革命性的创新。到2017年,LSTM已经在30亿设备上得到运用,每天由全球数家市值最高上市公司的用户发起的使用请求多达数十亿次。LSTM显著改善了超过20亿台Android手机的语音识别功能(2015年起);谷歌翻译使用LSTM大幅改善了机器翻译的质量(2016年起);Facebook每天使用LSTM技术执行逾45亿次自动翻译(2017年);苹果公司在约10亿台iPhone的Siri和Quicktype功能中采用了LSTM技术(2016年起);亚马逊公司的Alexa语音助手也采用LSTM技术来回答问题(2016年起);还有各种数不胜数的其他应用也采用了LSTM技术。2011年,他的团队率先借助深度神经网络技术赢得了一项官方举办的计算机视觉识别大赛,并且识别能力超过了人类;2012年,他们又率先借助深度神经网络技术赢得了一项以检测癌症为主题的医疗影像识别大赛。这些成就无不引起了业界的极大兴趣。

此外,它的研究小组还涉足元学习、数学严谨的通用AI,以及在通用问题求解中通过自我学习实现递归自我改善(1987年起)。在1990年代,他在研究中引入了无监督对抗神经网络,这些神经网络通过极大极小博弈 (minimax) 的方式相互竞争,以实现人工好奇心等特性。他的创造力,好奇心和乐趣的正式理论解释了艺术,科学,音乐和幽默。他提出的有关创造力、好奇心和乐趣的形式理论可以为艺术、科学、音乐和幽默提出解释。他还概括了算法信息论和物理学中的多世界理论,并且引入了「低复杂度美学」的概念,也就是信息时代的极简艺术形式。他在研究生涯中获奖无数,写作了超过350篇经过同行评审的论文,并且频繁现身大型活动的主题演讲。他是NNAISENSE公司的首席科学家,该公司肩负着率先实现实用的通用AI的使命。他还向许多政府机构提供有关AI战略的建议。