作者: John Blyler

在上一篇文章原创深度 | 协作机器人:模仿人类的复杂性仅仅是个开始(一)中,我们讲解了复杂感知系统的要求。本文我们将通过举例来理解协作机器人的协作复杂性。

协作的复杂性

人类使用多种感官来运动、操作和交流。一个常见的例子是肢体语言比如在使用不同手势时还会使用语音命令。对于协作机器人来说这种形式的协作需要视觉识别来完成手势识别、语音识别来理解不同的命令,以及借助人工智能(AI)来理解与人类交流时的内容。托尼就是采用这些技术才实现了与Dum-E的沟通交流。

我们继续深入探究这一点,这次我们举一个通过视觉和触觉(或触摸)反馈结合感官理解的例子,实际生活中外科医生在实际操作之前都会进行模拟手术(图1),模拟过程是创建一个虚拟现实(VR)的场景,外科医生可以在该场景中查看和测试手术的整个过程,然而模拟过程中是无法感受到手术刀与人体组织接触的感觉。这就是触觉反馈的作用所在,因为它能够帮助模拟过程中的触觉和力量。

机器怎样通过触觉实现交流呢?触觉反馈最常见的形式是通过振动来实现的,比如抖动产生的感觉,但是还有些是静音的,比如手机。以外科手术为例,线性的驱动器可以取代振动电机,当外科医生对模拟手术刀施加压力时,线性驱动器可以上下移动对身体的某一部分施加一定的压力,这个压力对应的就是模拟手术刀上的压力。

以协作机器人为例,协作机器人的抓手(或手)装置中采用了触觉反馈设计,这些抓手通常包含一个用于识别被握持物体的手腕摄像头,以及为触觉提供输入力——力矩转化的传感器。

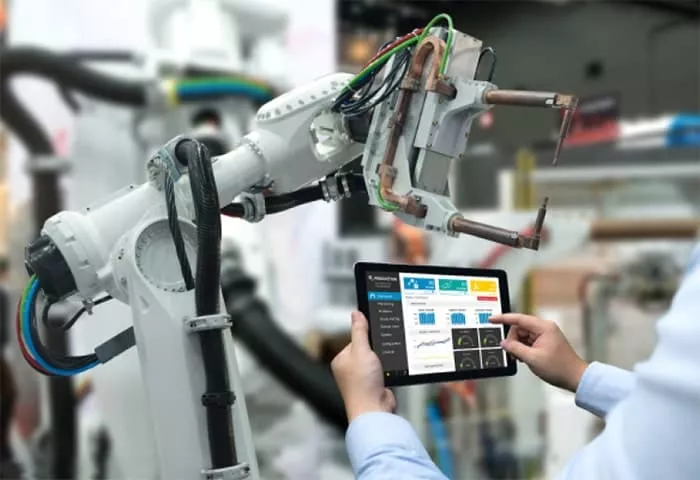

大多数工作人员通过按钮、操纵杆、键盘或数字接口(图2)来与协作机器人实现交流和控制,然而这就像它们对人类一样,语音和触觉可以成为协作机器人更加有效交流的媒介。

触觉和眼睛的移动是另一种感官组合,同样可以帮助改善人类与协作机器人之间的互动方式。当人类要指向一个物体时,它会先朝着这个物体的方向看,协作机器人的视觉传感器可以捕捉这种预期行为,从而提供关于人类的行为的判定结果,同样技术也可以帮助协作机器人将这种判定结果传达给人类。现在机器人可以借助投影仪将目标物体或者行动路线照亮。

总结

与任何新兴的技术一样,实现协作机器人与人类更加高效的交流工作仍然面临着许多的挑战,就像“钢铁侠”中托尼·斯塔克(Tony Stark)一样,人类会不会觉得协作机器人会更令人沮丧而不是更加有用呢?

如今大多数机器人都集成了高级的语音和视觉识别功能来帮助人类,然而协作机器人缺乏的能力是对连续内容的理解以及对复杂情况及时做出反应。人工智能对于协作机器人实现真正的交互、预测和沟通是至关重要的,尤其是当它们需要将某些复杂的任务交给人类来处理时,这在自动驾驶汽车领域是一直存在的问题。

比较乐观的是在“钢铁侠”这部电影接近尾声的时候,托尼·斯塔克因为无法拿到旁边桌子上的人造心脏而奄奄一息的关键时刻,Dum-E弄清楚了托尼的意图并及时帮助了他,挽救了托尼的生命。托尼抬头看着Dum-E说到“好孩子”。协作机器人与人类之间建立这种程度的信任或许是目前最困难也是最有价值的目标了。

相关阅读:

原创深度 | 协作机器人:模仿人类的复杂性仅仅是个开始(一)

原文链接:

https://www.mouser.cn/applications/collaborative-robotics-complexity-mimicking-humans/

该发布文章为独家原创文章,转载请注明来源。对于未经许可的复制和不符合要求的转载我们将保留依法追究法律责任的权利。